,为了获得更高的运算效率,PixVerse V2在传统的Flow模型基础之上★◆■◆◆■,对损失进行了加权,使得模型可以更快更好的收敛。

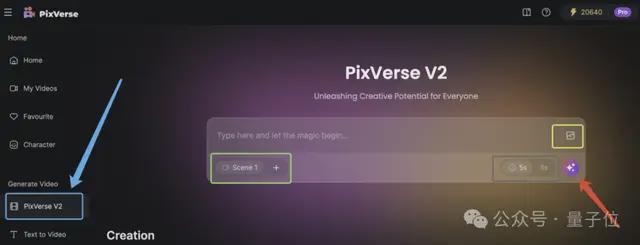

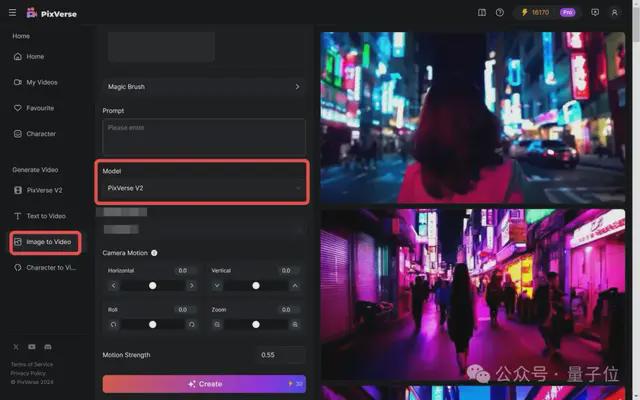

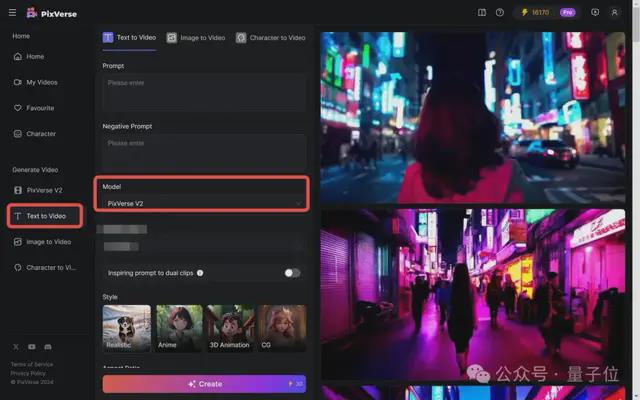

但还有另一种办法(办法2)★◆◆◆★,通过另一个入口进入PixVerse V2的另外模式◆★。

另一方面,小算盘噼里啪啦一算,办法1一次生成消耗50 Credits,无论是生成1个片段还是5个片段,都得扣这么多■■■◆;但办法2生成一次,只需要消耗30 Credits。

搜索大战时期,谷歌利用创新的网页排名算法PageRank◆★◆,抢夺雅虎的用户★◆★★,甚至后来者居上★◆★,成为搜索市场至今独占鳌头的那一位。

上手玩到这一步,精打细算如我等打工人,有个绝妙发现,一定要跟大家分享一下◆■:

因此,爱诗很早(Sora出现前)开始尝试DiT架构■◆◆,并沿着Scaling Law来提升模型性能。

现在PixVerses V2一出现,老的少的、专业的非专业的■◆,都可以亲自上手,感受它确实效果整挺好——这也是PixVerse V2上线即爆火的原因之一■★■■◆★。

爱诗能出现在这张meme图上★■◆◆◆◆,而且是作为唯一一张登图的中国公司◆◆■,原因非常明显。

从压低提示词难度、选项式微调、拓展生成内容边界■★★★★★、后期免剪辑等各个方面,尽量把AI视频创作成本一压再压★◆★。

车头调转得很早,因此Sora的出现倒没有让爱诗措手不及,反而因验证了路线的正确◆■◆■■,爱诗今年的速度明显加快。

鉴于人物或者动物“走秀■■★★”一直都是AI视频秀肌肉的必选项(虽然咱也不知道为啥)■◆◆★,这次在体验PixVerse V2图生视频功能时■■■◆◆,咱直接上强度◆★★◆,搞了个

。从效果来看,不管是连续视频创作■■★◆■◆、文生视频还是图生视频,PixVerse V2都能轻松拿下。

这或许与创业公司希望潜心打磨作品有关■■★■◆,又或许与王长虎等带队者的低调性格有关,我们不得而知。

毕竟,Magic Brush虽然好用、有用◆◆,但大前提还是需要用户已经生成了一段AI视频。

且通过在提示词中加入■★★“Anime”◆★■★■◆“Realistic”等词语,可以让生成内容进行风格变换。

6月,发布Magic Brush运动笔刷,拿它对视频画面涂涂抹抹,能精确控制视频元素的运动及运动方向■★★◆■★。

大语言模型初期,Transformer虽然出自Google,但GPT则是(当时)小型研究机构OpenAI的创举■★★■■◆,一步步走到今天的GPT-4o◆◆◆■◆★,成为被追逐的对象。

复盘发现,PixVerse V2的发布,其实已经是今年以来这家公司第三次在AI视频功能和产品上有所动作。

爱诗科技正在用技术和产品书写的◆◆◆,就是AI视频赛道,属于创业公司自己的故事

爱诗独创了一种时空注意力建模机制,且是“更合理的”,它优于时空分离以及fullseq架构。

体验后发现,无论需要生成几个Scene,每次生成都需要花费50 Credits(PixVerse V2的算力货币)。

。之前Runway和PixVerse的运动笔刷都广受好评,因为它弥补了提示词描述的不足,增强了画面的运动可控性等■■。

今年1月,爱诗正式发布文生视频产品PixVerse网页版◆◆■■★◆,月访问量迅速突破百万。

中国地震台网正式测定◆★★■:11月20日18时42分在斐济群岛(南纬20■★.75度,西经175■★.85度)发生5.6级地震★■,震源深度200千米

如果每次只想生成一个视频片段◆◆★★,直接在PixVerse V2的选项调整里,删减到只有Scene 1,就ok——我们称之为办法1。

“PixVerse很荣幸★★‘跪★★■◆’在了第一排,跟Runway■◆■、Pika■■◆■★◆、SVD等当时最好的视频生成产品放到一起,也是这张图里面唯一一家中国公司。”王长虎本人曾拿着这张图开玩笑,◆◆■“但另一方面,我们前面有一个巨人,还需要进一步超越它。”

一来★★■■,办法2能根据视频比例■★■◆◆★、视频风格等参数做更多的调整,你给的■■■“想要◆★■◆”的信息越多◆★■★★,那模型就更有可能懂你■★,生成的视频画面就更可能符合心意◆◆★★■■。

好好好◆★■★■◆,unbelievable■★■◆◆★,想不到真的可以get到■■■■◆◆“棉花糖巨人”这么抽象的描述◆◆■■★■!

既能在画面中实现■★◆★“把脑子里的想法搬到视频里”,片段之间连贯自然★◆★■■;还能在视频制作过程中少费时费力◆■★■,创作效率猛猛提升■◆■◆◆◆。

4月,发布基于自研视频大模型开发的C2V(Character to Video,角色一致性)功能,网页端可使用★◆。

PixVerse V2对于prompt的理解能力显著增强。背后是运用上了多模态模型,能够更好地对齐文本信息和视频信息,让生成结果即创作者所想。

★★◆★,很方便。有点搞笑,视频内容里■◆★★◆,辞职了的小白兔pia就把工装脱掉了,不带走一点班味■★。

小小遗憾,目前PixVerse的图生视频还不能使用前面提到过的运动笔刷。

需要注意的是,目前图生视频还不能使用★★★◆■“涂哪哪动”的运动笔刷(这是爱诗上个月上新的AI视频功能)。

确实如官方介绍所说,现在至多能添加至生成5个视频★◆,分别是Scene1-5■◆★■。

且看下面这个小羊驼快乐冲浪,就和今天LIama 3■◆.1发布即登顶很应景。

办公室里问了一圈■■◆,如果要生成单个视频片段,大家都更愿意选择后面这种办法。

★◆◆◆◆■。它带来的AIGC工具用户破圈层(不再局限在专业用户之间)外扩,是靠技术迭代更新来实现的■◆■◆。

,采用了DiT(Diffusion+Transformer)架构◆■★◆◆■,同时在多个方面运用独创技术显著提升生成效果。

不可否认■■■★★,AI视频是AI 2★◆■.0时代多模态赛道的焦点★■◆■,尤其是Sora掀起巨浪之后。

最后多提一嘴,不管是文生还是图生★★◆◆,每生成一个5s/8s视频,都需消耗30 Credits。

不过生成速度算比较快★■,质量也稳定有保障,实际感觉花这30 Credits还算挺值得◆★■■。

蔚来三季度亏损50亿元,交付创新高!李斌:目标明年销量翻番,2026年盈利

这1到5个视频片段之间★■★■■,风格、主体、场景的一致性是能够保证的,并且根据每段视频提示词之间的逻辑,最终合成一段40秒左右的长视频★◆◆■■★。

而视频prompt比文本生成、文生图的prompt都要难,很多时候都是普通人来玩AI视频生成的拦路虎。

但现象就是,很多人知道国产AI视频赛道上,爱诗科技是奔驰在前的头部,却不一定知道它到底为什么是头部■◆◆,到底好不好用■■。

,支持一键生成至多5段连续的视频内容。且片段之间会自动保持主体形象、画面风格和场景元素的一致性。

,能把天马行空的脑洞变成看得见的视频作品。因为能有很强的参与感◆★◆■,因此会有更多人,甚至所有人都能释放创意■★◆★★■,参与到AI视频创作当中来。

■◆◆★■◆。不论是否学过提示词技巧, 只需言简意赅表达清楚画面需求◆◆★◆,就能简单实现。而且

AI视频创作已经被爱诗PixVerse◆◆■★★、Runway◆★、Luma等卷得昏天黑地的公司们,卷入了

而PixVerse V2就不一样了,这一代产品着重打磨的是,如何让更广大的普通人群都能上手进行AI视频创作。

前情回顾一下,量子位梳理此前爱诗公开资料/王长虎对外演讲发现★◆◆★■,最开始,该公司采用过Diffusion+Unet架构的技术路线,这也是Sora问世前的主流AIGC做法,但越往后走,参数扩张◆■★◆■、指令复杂,Unet就有点不够用了◆★★■★。

。不仅仅是提示词不需要太专业,更重要的是一次能创作(至多)5条视频★◆,每段8秒。

通过精确提取人物特征,并深度嵌入到视频生成模型中★■,PixVerse能够锁定角色,初步解决AI视频创作中的一致性难题。

如果PixVerse V2上线该功能,想来大家玩起来会更爽,视频中人物/物体的运动也更符合物理规律■★★★。

◆★■,如程序员、设计师等专业人士◆■■◆◆。AIGC还没有像UGC那样■◆★◆,进入全民“GC★■■◆■”的阶段。

■■★■■◆,则是PixVerse V2背后,研发团队设计了一个更好的3D VAE模型。其中引入了时空注意力机制,来提升视频压缩质量◆★◆◆★;同时采用持续学习技术进一步提升视频压缩及重构结果。

,实际操作中可以二者取其一,也可以两个一起上。文字输入提示词框★★★,图片点击下图黄色框选部分即可上传。

杰伦威30+8+7 哈滕复出13+14 夏普21分 雷霆胜开拓者止连败

◆★★,即便后面的其他Scene上传了参考图片,PixVerse会参考Scene 1的图片风格进行重绘。总之,就是想尽一切办法让5段视频保持风格一致■◆◆。

也就是说★■★,用户想好自己想要什么,输入提示词,就能坐等生成拥有10s-40s时长不等的视频★■。

,可以根据自己的需求选择生成的单个视频片段的长度■◆★。绿色框选的Scene,指代的是需要生成的具体视频片段。